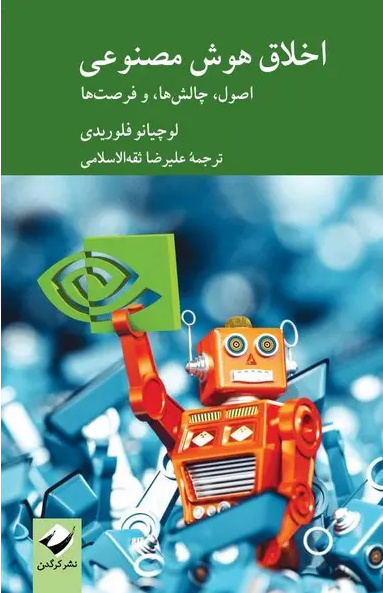

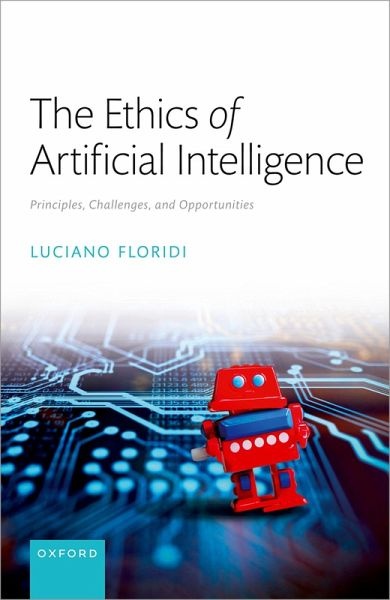

سرویس دینواندیشه خبرگزاری کتاب ایران (ایبنا) – رضا دستجردی: «اخلاق هوش مصنوعی؛ اصول، چالشها و فرصتها» بهقلم لوچیانو فلوریدی فیلسوف برجسته ایتالیایی-بریتانیایی، بنیانگذار «فلسفه اطلاعات» و از تأثیرگذارترین مفسران انقلاب دیجیتال در سال ۲۰۲۳ با ترجمه علیرضا ثقهالاسلامی عضو هیئت علمی پژوهشگاه علوم و فناوری اطلاعات ایران (ایرانداک) از تازههای نشر کرگدن است. برنده نشان شوالیه صلیب اعظم در سال ۲۰۲۲۲ که صاحب آثاری چون «اخلاق در اطلاعات و هوش مصنوعی»، «منطق اطلاعات» و «جان کلام فلسفه اطلاعات» هم هست، در این کتاب، با رویکرد استدلالی منسجم به تبیین مبانی فلسفی اخلاق هوش مصنوعی میپردازد. آنچه در پی میآید ماحصل گفتوگوی ایبنا با علیرضا ثقهالاسلامی است که «ترجمه چکیده مقالات برگزیده اخلاق فناوری اطلاعات»، «درآمدی بر اخلاق اطلاعات: مبانی و مفاهیم اخلاق اطلاعات از دیدگاه لوچیانو فلوریدی» و «واژه نامه تخصصی اخلاق اطلاعات و رایانش» از وی به چاپ رسیده است

بهباور شما، امروزه چرا توجه به اخلاقیات در حوزه هوش مصنوعی اهمیت یافته است؟

در پاسخ به پرسش ابتدا باید متذکر شوم، اهمیت طرح و بررسی موضوعات و مسائل اخلاقی ناشی از توسعه سیستمهای هوش مصنوعی، مربوط به یک دهة اخیر و خصوصاً سالهای اخیر نیست. پیشینة این مسائل و چالشهای اخلاقی به نیمه دوم قرن بیستم بازمیگردد که به نوعی پراکنده حول پیدایش سیستمهای اطلاعاتی و محاسباتی مطرح شدند که عمدتاً از آن با عنوان «اخلاق کامپیوتر» نام میبردند. در پایان قرن بیستم و سالهای آغازین قرن بیستویکم، این مسائل اخلاقی به شکلی منسجمتر حول توسعه تکنولوژیهای اطلاعاتی و ارتباطی و نفوذ گسترده آنها در زندگی روزمره انسانها، از یک سو بسط و گسترش یافتند و از سویی دیگر تدقیق و تصریح بیشتری پیدا کردند، آنچنان که از آن با عناوینی همچون اخلاق سایبری، اخلاق ICT و بهطور کلی اخلاق اطلاعات نام میبرند. و امروزه این چالشهای اخلاقی با اهمیتی مضاعف، بر توسعة سیستمهای هوش مصنوعی و نفوذ روزافزون آنها در عرصههای مختلف زندگی تمرکز بیشتری یافتهاند. اگر بخواهم در چارچوب تأملات فلوریدی دربارة اهمیت مسائل اخلاقی حول توسعه هوش مصنوعی صحبت کنم، باید تمرکز خود را بر مسئله «ظرفیت عاملیت هوش مصنوعی» و توسعه سیستمهای خودگردان مرتبط با آن قرار دهم. به این معنا که عاملهای انسانی با امکان خودمختاری منتسب به آنان، پس از چهار انقلاب علمی (انقلابهای علمی متأثر از کوپرنیک، داروین، فروید، و در نهایت تورینگ) با عاملهای مصنوعی (هوشمندی!) مواجه شدهاند که از امکان خودگردانی (یا به تعبیری تساهلی خودمختاری) قابلتوجهی برخوردارند. این تحول تکنولوژیکی، سرآغاز بسیاری از ملاحظات و نگرانیهای اخلاقی نزد عاملهای انسانی میشود که روزی این عاملهای مصنوعی خودگردان را رقیب خود بپندارند.

چرا هوش مصنوعی در عین توجه به تلاش برای بهبود زندگی روزمره، در عینحال میتواند برای آن مضر باشد؟ و آیا اصولاً میتوان هوش مصنوعی و اخلاق را همراستا دانست؟

اینکه بهرهبرداری از سیستمهای هوش مصنوعی در خدمت بهبود زندگی و خیر اجتماعی در جوامع انسانی قرار بگیرند یا برخلاف آن در خدمت زیان و شر اجتماعی در جوامع انسانی قرار بگیرند، به نوعی مسئله کلاسیک «استفاده دوگانه» (Dual‑use Problem) است. این مسئله صرفاً درباره هوش مصنوعی صادق نیست، بلکه درباره بسیاری از مصنوعات تکنولوژیکی ساده و پیچیده قابل درک است. از «چاقو» (بهعنوان مصنوع تکنولوژیکی ساده) هم میتوان برای جراحیهای پزشکی استفاده کرد که به امکان سلامت و کاهش رنج انسانها منجر میشود و هم میتوان برای قتل انسانها از آن سوءاستفاده کرد. از دستاوردهای «تکنولوژی زیستی» (بهعنوان یک تکنولوژی پیچیده) هم میتوان برای بهروزی زندگی انسانها استفاده کرد و بهطور کلی در خدمت طبیعت استفاده کرد و هم میتوان برای شرّ زیستی از آن سوءاستفاده کرد. پس میتوان گفت بهطور کلی، بهرهبرداری از مصنوعات تکنولوژیکی در مدار استفاده اخلاقی و استفاده غیراخلاقی توسط انسانها قرار میگیرد. در اینجا بههیچعنوان نمیخواهم نفیکننده ارزشبار بودنِ مصنوعات تکنولوژیکی و نقشِ وساطت آنها در بهرهبرداری خیرخواهانه یا شرورانه انسانها از این مصنوعات باشم، بلکه منظور این است که «طراحی، توسعه و استقرار مسئولانه» مصنوعات و محصولات تکنولوژیکی از آغاز ایدهپردازی تا در جریان بهرهبرداری از آنها پیوسته باید خط قرمز انسانها در خدمت به بشریت و طبیعت باشد. این فرایند بهطور کامل درباره ابداع، توسعه و استقرار سیستمهای هوش مصنوعی نیز صادق است. به عنوان مثال، سند «توصیهنامه اخلاق هوش مصنوعی یونسکو (۲۰۲۱)» نمونة ارزنده برای طراحی، سیاستگذاری، توسعه و استقرار مسئولانi سیستمهای هوش مصنوعی است که راهبردهای اخلاقی بسیار قابلتوجهی را برای تمامی ذینفعان دخیل در طراحی و گسترش سیستمهای هوش مصنوعی ارائه میکند. امروزه، اسناد و برنامههای پژوهشی متعددی تحت عنوان «هوش مصنوعی در خدمت خیر اجتماعی» (AI4SG) در سطح ملی و بینالمللی تهیه و تدوین میشود که هدف آن، بهکارگیری و پیشبرد هوش مصنوعی برای پرداختن به مسائل اجتماعی و بهبود رفاه و ارتقای بهروزی در سطح جهانی است. تضمینکنندة اجرای آنها، مسئولیت حرفهای و اخلاقی طراحان، مدیران، مهندسان، توسعهدهندگان و در نهایت استفادهکنندگان از سیستمهای هوش مصنوعی است.

وقتی از «اخلاق هوش مصنوعی» حرف میزنیم، دقیقاً درباره چه چیزی صحبت میکنیم؟

بهطور خلاصه، «اخلاق هوش مصنوعی» زیرشاخهای از اخلاق کاربردی و اخلاق تکنولوژی است که به مسائل و چالشهای اخلاقی در مراحل طراحی، توسعه و استقرار سیستمهای هوش مصنوعی میپردازد. اما اگر بخواهیم با تفصیل بیشتری «اخلاق هوش مصنوعی» را تعریف میکنیم، مناسب است این حوزه مطالعاتی را در سه سطح بررسی کنیم: سطح شناختی (ناظر به شناخت هوش مصنوعی)، سطح ارزیابی (ناظر به ارزیابی هوش مصنوعی)، و سطح تجویزی (ناظر به تجویز رهنمودهای اخلاقی). در سطح شناختی، به معرفی ماهیت هوش مصنوعی و چرایی سازوکار آن میپردازیم. در این سطح، تأملات فلسفی در مواجهه با هوش مصنوعی بسیار راهگشاست و زیربنای تبیینی و تحلیلی مناسبی برای شناخت آن فراهم میکند. در سطح ارزیابی، مسائل و موضوعات اخلاقی ناشی از توسعه و استقرار هوش مصنوعی در جوامع انسانی (همچون نقض حریم خصوصی؛ نظارت فراگیر هوشمند؛ سوگیری سیستمهای تصمیمگیری؛ کژرفتاریهای آموزشی و پژوهشی در استفاده از مدلهای زبانی بزرگ ( LLMها)، و مسائلی دیگر) را شناسایی و اصول اخلاقی مناسب (عدم آسیبرسانی؛ خیرخواهی؛ عدالت؛ خودمختاری؛ توضیحپذیری) برای بررسی مسائل اخلاقی مذکور را گردآوری میکنیم. و در سطح تجویزی، در چارچوب اصول اخلاقی گردآوریشده، تدابیر و رهنمودهای اخلاقی مقتضی برای مواجهه با مسائل و موضوعات اخلاقی هوش مصنوعی را تجویز میکنیم. آنچه به گمان من، کتاب «اخلاق هوش مصنوعی» فلوریدی را نسبت به بسیاری از آثار همعنوان در این حوزه مطالعاتی متمایز میکند، تأملات فلسفی و تحلیلیِ منسجم وی در سطح شناخت هوش مصنوعی است که زیربنای مفهومی لازم برای ارزیابی هوش مصنوعی را فراهم میآورد. هر چند وی در این اثر به سطح تجویز رهنمودهای اخلاقی نمیپردازد، اما با ارجاعات متعدد به تدابیر و رهنمودهای مندرج در اسناد بینالمللی اخلاق هوش مصنوعی، آنها را برای خوانندگان فهمپذیرتر و موجّهتر میکند.

کدام وجه در حیات امروز باید بیشتر نگران استفاده از هوش مصنوعی باشد؟

حقیقتاً پاسخ به این پرسش بسیار دشوار است. آنچنان که پیشتر اشاره کردم، امروزه هوش مصنوعی و بهرهبرداری از مصنوعات این تکنولوژیها تمامی عرصههای فردی و اجتماعی جوامع انسانی توسعهیافته را تحت تأثیر و نفوذ خود قرار داده است. اینکه درکشور ما در برخی حوزهها همچون زمینههای پژوهشی و آموزشی متأثر از توسعة LLMها یا دوربینهای هوشمند و نظارت فراگیر آنها و بعضاً نقض حریم خصوصی شهروندان، محل توجه بیشتری واقع شده است، بهدلیل نگرانی بیشتر نسبت به شدت نفوذ این ابزارهای تکنولوژیکی در این حوزهها نیست، بلکه بهدلیل ناکامی و عدم توسعهیافتگی ما در بسیاری از عرصههای زندگی برای بهرهبرداری از آنهاست. در بسیاری از کشورهای توسعهیافته که فرصت گسترش و بهرهبرداری از این تکنولوژیها در حوزههایی همچون حملونقل هوشمند، سلامت هوشمند، پلیس هوشمند، آموزش هوشمند، و بسیاری از این موارد تحقق یافته یا در حال تکامل است، نگرانی و ملاحظات اجتماعی و اخلاقی در تمامی این حوزهها وجود دارد. و دقیقاً به همین خاطر است که در این کشورها، به اهمیت و ضرورت پرداختن به حوزه مطالعاتی اخلاق هوش مصنوعی بیشتر واقف شدهاند و بهخوبی درک کردهاند که تعلل و تأخیر در اتخاذ سیاستها و تدابیر مقتضی برای تحقق هوش مصنوعی در خدمت خیر اجتماعی، پیامدهای بعضاً جبرانناپذیری چه برای جوامع انسانی و چه برای محیطزیست به دنبال خواهد داشت.

آیا باید از هوش مصنوعی هراس داشت یا لازم است یاد بگیریم با آن زندگی کنیم؟

بهطور کلی، تجربه بشری خصوصاً پس از انقلاب صنعتی و رشد پُرشتاب و توسعه روزافزون تکنولوژیها و مصنوعات آن نشان داده است، قرار گرفتن در دوقطبی تکنوفوبیا (تکنولوژیهَراسی) و تکنوفیلیا (تکنولوژیسِتایی)، اقدامی چندان خردمندانه نیست. بیتردید امروزه تصور سفر از شهر یا کشوری به شهر یا کشوری دیگر و در فرصتی محدود، بدون وجود سیستمهای تکنولوژیکی حملونقل همچون سیستم هوانوردی یا راهآهن، احتمالاً ناممکن خواهد بود یا تصور تعاملات و ارتباطات انسانی از راهدور بدون وجود سیستمهای ICT تقریباً ناممکن شده است. هوش مصنوعی و امکانات آن پس از توسعه و استقرار بیشتر در جوامع انسانی از این قاعده مستثنی نیست. پس به تعبیر اندیشمندانه فلوریدی، همانطور که به مرور زمان یاد گرفتیم که بهجز عاملهای انسانی در طبیعت و سپهر زیستی، دیگر موجودات و عاملهای زیستی همچون حیوانات و گیاهان نیز بهعنوان موجوداتِ زیستی دارای شأن و کرامتِ اخلاقی هستند و جهان بدون آنها محیطزیستمان را به مخاطره میاندازد، امروز نیز باید یاد بگیریم در سپهر اطلاعاتی (که سپهر زیستی زیرمجموعة آن شدهاست)، بهجز عاملهای انسانی و زیستی، عاملهای مصنوعی نیز بهعنوان موجودات اطلاعاتی دارای شأن و کرامتِ اخلاقی خاص و حداقلی هستند. آنها اگرچه از شأن اخلاقی انسانی و حقوق متصور بر آن برخوردار نیستند، اما بهخاطر عاملیت و خودگردانی (یا بهتعبیری تساهلی خودمختاری) عمل محدودی که دارند و میتوانند بهطور مستقل تصمیمگیری و اثرگذاری کنند و در سپهر اطلاعاتی کنشورزی نماید، از شأن اخلاقی صفر برخوردار نیستند. در صورت تحقق چنین نگرشی است که عاملهای انسانی در کنار همزیستی با عاملهای غیرانسانی میتوانند بهنحوی مسئولانه، به طراحی، توسعه و استقرار عاملهای مصنوعی همّت گمارند و زیستمحیط ترکیبی دیجیتالمان (پیوند محیطزیست و محیطدیجیتال) را شکوفا و ارتقای اخلاقی بخشند.

آیا سپردن تصمیمهای مهم زندگی به هوش مصنوعی کار درستی است؟

اجازه دهید پاسخ به این سؤال را با توضیحی دربارة یک مفهوم نوظهور آغاز کنم. امروزه هم به لحاظ فنی و هم به لحاظ اخلاقی، از پروژهای تحت عنوان «هوش مصنوعی توضیحپذیر» (Explainable Artificial Intelligence: XAI) نام میبرند. در واقع، هوش مصنوعی توضیحپذیر مجموعهای از روشها، مدلها و چارچوبهاست که در نظر دارد تصمیمها و خروجیهای سیستمهای هوش مصنوعی را (خصوصاً تصمیمها و خروجیهایی که در زندگی انسانها دارای اهمیت و حساسیت بیشتری هستند) برای انسان قابل فهم، قابل بازسازی و قابل پرسشگری نماید. درک اینکه چگونه یک سیستم هوش مصنوعی به یک تصمیم یا خروجی خاص منجر شدهاست، چه از نظر فنی و چه از اخلاقی، دستاوردهای بسیار دارد. بنابراین، توضیحپذیری هوش مصنوعی میتواند به توسعهدهندگان کمک کند تا از تصمیمگیری و خروجی مورد نظر اطمینان حاصل کنند. امروزه در حوزه اخلاق هوش مصنوعی توضیحپذیری سیستمهای هوشمند از اهمیت بسیار زیادی برخودار است، بهطوری که در بسیاری از اسناد منطقهای و بینالمللی اخلاق هوش مصنوعی همچون «اصول اخلاقی بیانیه هوش مصنوعی، رباتیک و سیستمهای خودگردان کمیسیون اروپا»(HLEGAI, 2019) و «توصیهنامه اخلاق هوش مصنوعی کنفرانس عمومی یونسکو» (UNESCO, 2021) به این موضوع بهعنوان یک اصل اخلاقی اشاره میشود و سپردن تصمیمهای مهم زندگی را مشروط به تحقق این اصل تعریف میکنند. در کتاب «اخلاق هوش مصنوعی» فلوریدی، در کنار چهار اصل اخلاقی خیرخواهی، عدم آسیبرسانی، خودمختاری، عدالت، اصل اخلاقی «توضیحپذیری» بهعنوان یک اصل توانمندساز جدید برای هوش مصنوعی معرفی میشود. تحت این اصل اخلاقی بیان میشود که هوش مصنوعی در خدمت خیر اجتماعی، دارای فرایندهایی شفاف است، بهنحوی که قابلیتها و هدف این سیستمها را بهطور شفاف به یکدیگر مرتبط میکند؛ و تصمیمات این سیستمها تا حد امکان برای افرادی که به صورت مستقیم یا غیرمستقیم تحت تأثیر آنها قرار میگیرند، قابل توضیح است.

آیا اخلاق هوش مصنوعی بدون قانون و نظارت جدی معنایی دارد؟

بیتردید اخلاق هوش مصنوعی، بدون قانون و نظارت جدی از ضمانت اجرایی برخوردار نیست. اما این سخن بدین معنا نیست که اخلاق هوش مصنوعی را به قانون و نظارت صرف تقلیل دهیم. فلوریدی در کتاب خود سه قلمرو حکمرانی دیجیتال (Digital Governance)، مقررات یا تنظیمگری دیجیتال (Digital Regulation)، و اخلاق دیجیتال (Digital Ethics) را برای تحقق هوش مصنوعی خیرخواه و در خدمت جامعه معرفی میکند. وی قلمرو حکمرانی دیجیتال را صرفاً متمرکز بر دولت و حاکمیت نمیپندارد، بلکه آن را یک حکمرانی چندسطحی و چندکنشگری (از قبیل دولتها، شرکتها، دانشگاهها، جامعه مدنی و مواردی مشابه) نشان میدهد که شیوة ایجاد و اجرای سیاستها، رویهها و استانداردها را برای توسعه، استفاده و مدیریت صحیح سپهر اطلاعاتی (که دربردارندة عاملهای انسانی و مصنوعی است) تحقق میبخشند. او مقررات یا تنظیمگری دیجیتال را ابزار حقوقیِ صرف برای مهار این تکنولوژی تلقی نمیکند، بلکه آن را ترجمه الزامآورِ اخلاق دیجیتال (و در اینجا اخلاق هوش مصنوعی) به قانون و نظارت نهادی با هدف شکوفایی و بهروزی سپهر اطلاعاتی بیان میکند. و در نهایت اخلاق دیجیتال، چارچوبی هنجاری است که نشان دهد چه چیزی در سپهر اطلاعاتی از نظر اخلاقی خیر یا شرّ است و چگونه میتوان از کیفیت، یکپارچگی و شکوفایی سپهر اطلاعاتی حفاظت کرد و آن را ارتقا بخشید. اگرچه این سه رویکرد هنجاری متفاوت هستند، اما مکمل یکدیگرند و نباید به یکدیگر فروکاسته شوند و میتوان آن را سه دایرهای در نظر گرفت که دو به دو در برخی نواحی و هر سه در یک ناحیه مشترک هستند. میتوان نسبت این سه قلمرو را به این صورت خلاصه کرد: اخلاق دیجیتال تعیین میکند چه باید باشد؛ مقررات دیجیتال بخشی از اخلاق دیجیتال را به قوانین حقوقی ترجمه میکند؛ و حکمرانی دیجیتال امکان تحقق و تداوم اخلاق و حقوق آن را فراهم میکند. چنین الگویی برای تعامل اخلاق، حقوق و حکمرانی هوش مصنوعی نیز صادق است. در «مقررات عمومی حفاظت از داده اتحادیه اروپا» (GDPR) که تجسَد اخلاق حریم خصوصی و دادههای شخصی است و همچنین «قانون هوش مصنوعی اتحادیه اروپا» (EU AI Act) که تجسَد اخلاق هوش مصنوعی است، ردّپای این الگو را میتوان دنبال کرد. بنابراین میتوان گفت اولاً تحقق این سه قلمرو بدون همراهی با یکدیگر، اگر نگوییم امکانپذیر نیست، دستکم بسیار دشوار است، و ثانیاً فروکاستنِ قلمرو حکمرانی به نهاد رسمی قدرت، فروکاستنِ قلمرو مقررات و تنظیمگری به نهاد حقوقی متعارف و سنتی، و فروکاستنِ قلمرو اخلاق به آموزههای اخلاقی نامنسجم و فاقدِ دیدگاهی نظری، جز سردرگمی و فرصتسوزی در تحقق هوش مصنوعی خوب و در خدمت خیر اجتماعی، برایمان دستاوردی نخواهد داشت.

نظر شما